สวัสดีครับวันนี้ผมแอดเอฟ มาอยู่งาน Global Azure 2024 – Thailand ที่ Siam Paragon อีกเช่นเคย สำหรับงานวันนี้สายใช้ Cloud จาก Microsoft ชื่อว่า Azure บอกเลยห้ามพลาด เพราะทั้งหัวข้อ และ speaker แต่ละคนต้องบอกเลยว่าจัดเต็มมาก ไม่เชื่อมาดูหัวข้อกัน

#1 Deploy that Deno as a Function on Microsoft Azure

จากคุณจ๊อบ (Jirachai Chansivanon) จาก Microsoft

Deno เป็น runtime สำหรับ JavaScript และ TypeScript ที่ช่วยให้สามารถเขียนและรันโปรแกรม JavaScript / TypeScript บนระบบปฏิบัติการใด ๆ โดยไม่ต้องติดตั้ง Node.js หากเราลองดูดีๆ จะพบว่า Deno มันคือ Node กลับกัน 😆 เพราะว่าคนที่สร้าง Deno และ Node.js เป็นคนเดียวกัน

อีกอย่างสำหรับ demo ในวันนี้จะมีการใช้ Lib ที่เกิดมาพร้อมกับ Deno ชื่อว่า “FRESH” เป็น Lib แห่งความเปรี้ยวทั้งดีและไม่ดี เขียนโค้ดมาแล้วสามารถรันได้ทันทีเป็น just in time render หมายถึงแก้โค้ด แก้ content เห็นผลลัพธ์ได้ทันที พอใช้ Lib นี้ขั้นตอนในการ build จะหายไป สามารถทำเป็น SSR และใช้ File System ในการทำ Routing ได้แบบ Next.js เลย

Azure Functions เป็นบริการ serverless ที่ช่วยให้สามารถสร้าง API โดยไม่ต้องจัดการกับโครงสร้างพื้นฐาน โดย Azure Function จะรองรับ Runtime ที่หลากหลายไม่ว่าจะเป็น Node.js, Python หรืออื่นๆ แต่มันไม่ได้รองรับ Deno โดยเริ่มต้น แต่เราสามารถแก้ได้ 2 ท่าด้วยกันนั่นคือ

- ใช้เป็น Custom Handler ที่เป็นการ Custom Runtime

- Deploy เป็น Container ขึ้นไป (Demo นี้ใช้ท่านี้)

ตัวอย่างโปรเจกต์ที่คุณจ๊อบมา Demo ให้ดูจะอยู่ใน Repo นี้

antronic/dinosaur-deno-ts (github.com)

สำหรับท่านี้พอเราได้ Repo แล้วทำการ Fork มาแล้ว มันใช้เป็น Container เราก็จะต้องมาทำการสร้าง Dockerfile เสร็จแล้วเราก็ทำการ Build เป็น Docker image แล้วทำการ push ขี้นไปยัง

พอมันอยู่บน ACR แล้วเราก็มาทำการสร้าง Azure App Service สร้าง App Service ขึ้นมา แล้วก็ดึงจาก Azure Container Registry ได้

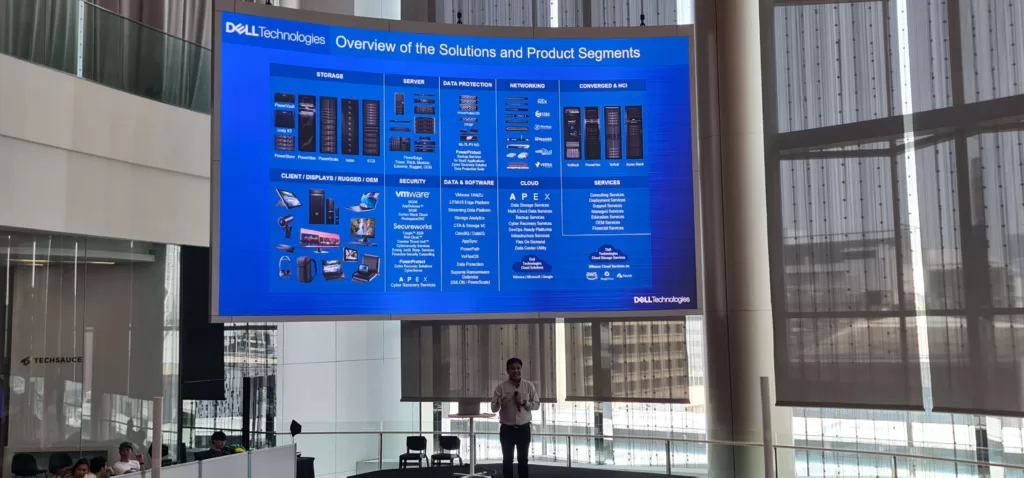

#2 Microsoft & Dell: Powering the Future with AI and Hybrid Cloud

จากคุณ Nopparat Tangseng เป็น Senior System Engineer จาก Dell

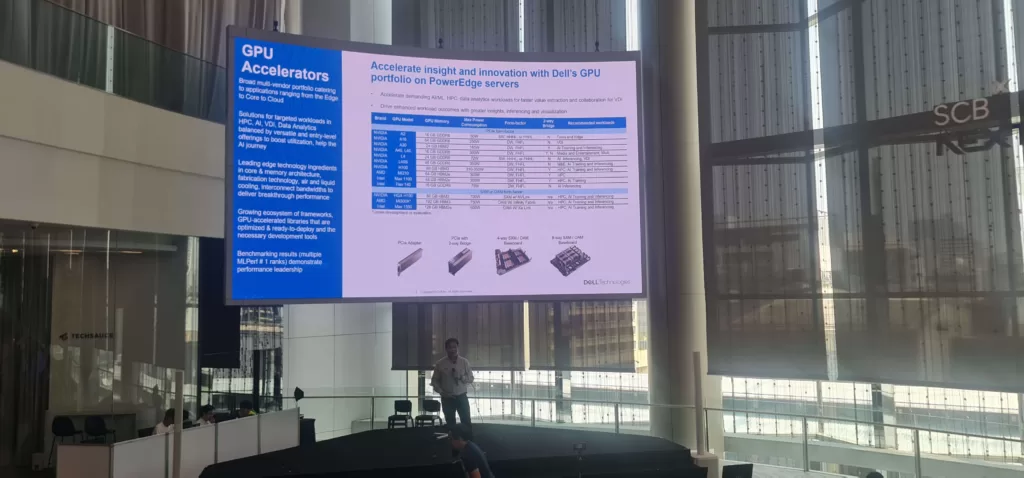

หากเราพูดถึง Hybrid Cloud ของ Microsoft เราก็จะนึกถึง Azure Arc ที่สามารถเอามาจัดการกับ Service บน Azure กับของที่อยู่บน Server ในองค์กร ตัวอย่างเช่น เราเอาโค้ดไปรันบน Azure แต่เอา workload มารันใน On-premise (ในที่นี้หมายถึง Dell) ซึ่งในปัจจุบันเรื่องของการเอา AI ML DL มาเทรนโมเดล ไม่ว่าจะเป็นการเทรนซ้ำ ๆ บ่อย ๆ จาก dataset จำนวนมากๆ เพื่อให้ได้ค่าความแม่นยำ ความถูกต้องสูงๆ ซึ่งพวกนี้แน่นอน จะต้องใช้ GPU การประมวลผลสูงๆ ซึ่ง Dell มี Hardware ประสิทธิภาพสูงที่เอามารองรับงานตรงนี้

หากเราพูดถึงเรื่องการย้ายการทำงานแบบผสมกันแล้วมักจะนึกถึงคำว่า Ground to Cloud (GC)หรือ Lift and Shift Cloud Migration คือตอนที่เอาจากข้างล่างขึ้นข้างบน อันนี้อาจจะไม่ค่อยยากเท่าไหร่ แต่ในทางกลับกันตอนที่เอาจากข้างบนลงมาข้างล่างหมายถึง service ต่างๆ นี้แหละคือความท้าทาย

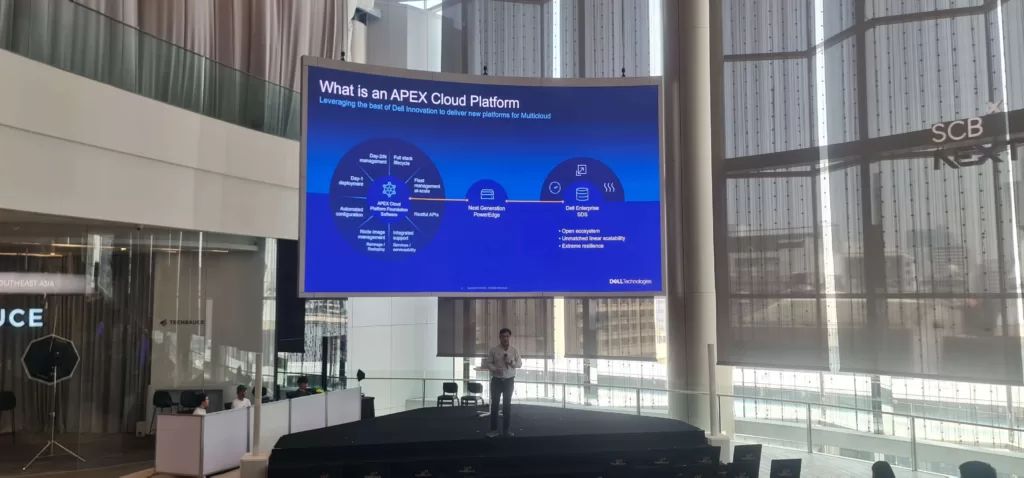

ซึ่งตอนนี้ก็จะมี Apex Cloud platform ที่จะเอามาช่วยลดความซับซ้อนในการติดตั้งและจัดการ Azure Stack และ Azure Arc services บนระบบภายในองค์กร โดยไม่จำเป็นต้องสนใจว่าเครื่อง server vของเราอยู่ที่ไหน ขอให้ต่ออินเทอร์เน็ตได้ ก็จะสามารถไปจัดการใช้งานกับ Service บน Azure ได้เลย

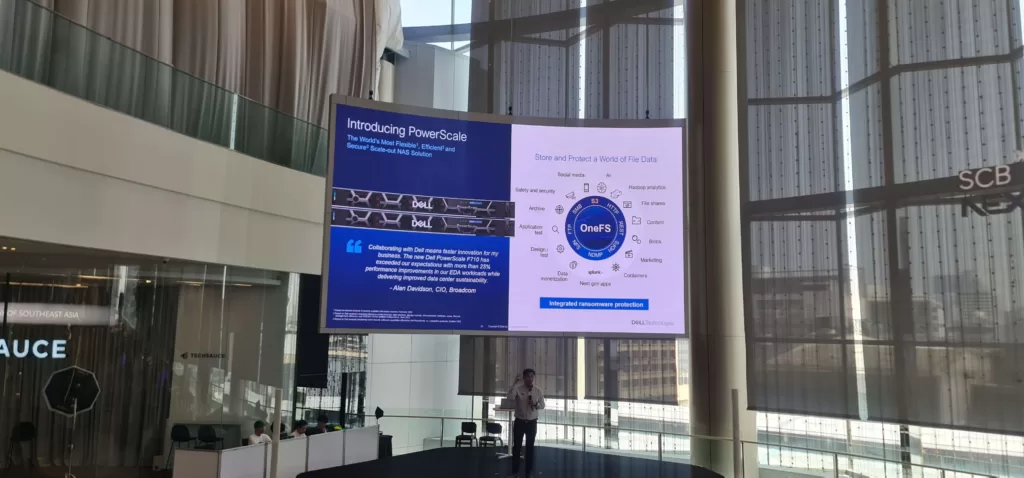

ต่อมาดูในฝั่งของพลังในเรื่องของ Data หรือห้องสมุดขนาดใหญ่ที่รวมของในการทำ ML เกี่ยวกับเครื่องมือที่ช่วยเก็บรวบรวม data พวกนี้มาทำ analytic ทำโมเดลต่าง ๆ โดย Dell เค้ามีเทคโนโลยีชื่อว่า OneFS มันคือ Lib ดีๆ ขนาดใหญ่ของสาย data นั่นเอง

OneFs นี่เป็นทางฝั่งของ Storage เปรียบง่ายๆ เป็นตู้เก็บเอกสารขนาดใหญ่ แต่ละชั้นวางของในตู้เปรียบเสมือนโหนดเก็บข้อมูลในคลัสเตอร์ OneFS จะช่วยให้เข้าถึงข้อมูลได้เร็วและง่ายขึ้น เอามาทำมาเทรน AI มาแบบเบิ้มๆ ชิลๆ

รวมไปถึงการมี AIOps ที่เป็นตัวช่วยดูเรื่องของความปลอดภัยใน service ที่ชื่อว่า CloudIQ และอื่นๆอีกด้วย

#3 Chatbot Magic: An overview of Prompt Flow in Azure AI Studio

จากคุณ Teerasej Jiraphatchandej

สำหรับ session นี้ของพี่พลเปิดมาที่คำถามว่า ใครใช้ AI บ้าง ? ซึ่งส่วนใหญ่เราใช้ในรูปแบบของการพิมพ์คุย ผลลัพธ์ก็ออกมาเหมือนเป็นเรียงความ หรืออาจจะปรับรูปแบบได้นิดหน่อยเป็นตาราง บลาๆ

เห้ย แล้วจะเตรียมตัวสร้างแอปที่เป็นการใช้งานการสร้าง Generative AI App cation เราต้องรู้อะไรบ้าง เริ่มยังไง?

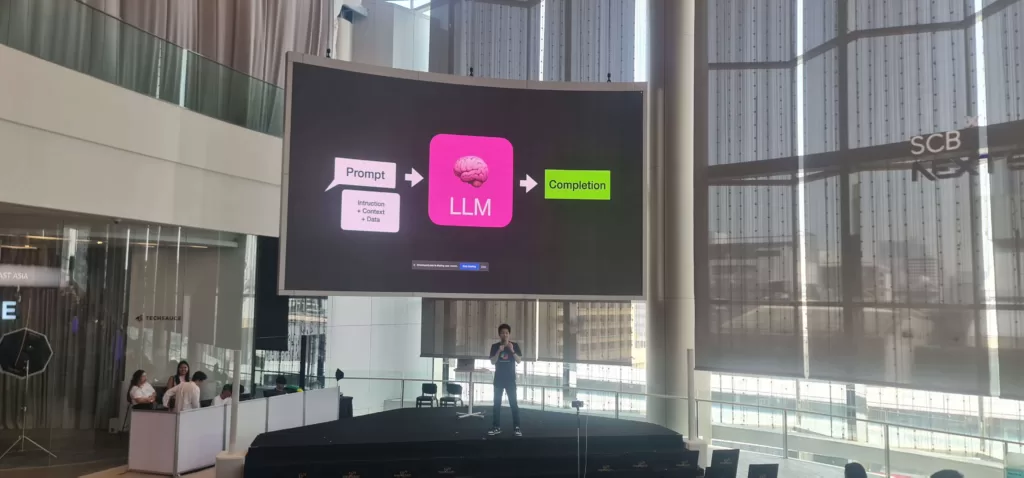

อยากแรกก็น่าจะเป็นการสร้างสมองหรือโมเดล LLM ที่มีหลากหลายโมเดล โมเดลก็จะมีหลายรุ่นหลายโมเดล

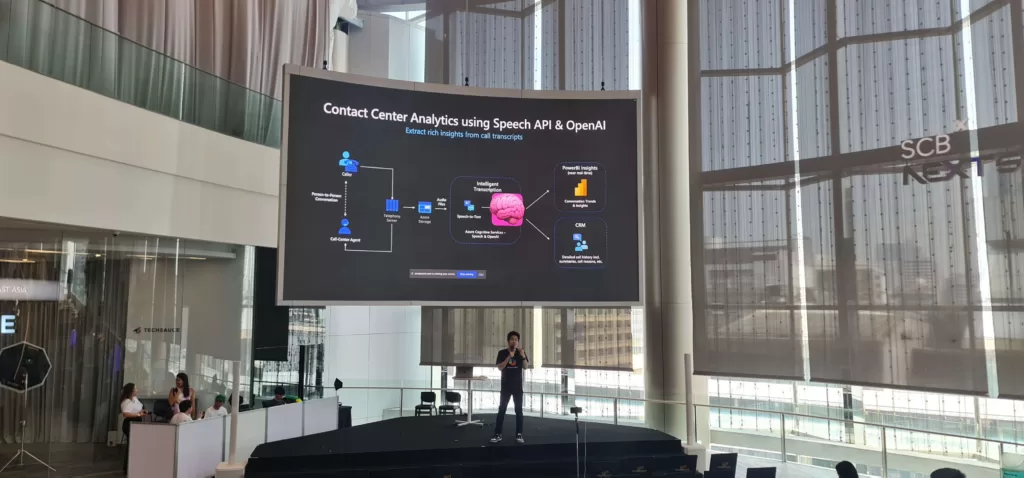

ต่อมาออกแบบ Prompt คำสั่งที่เราจะส่งให้ AI ประมวลผลแบบภาพด้านบน เหมือนมันจะง่ายนะ แต่ปัญหาคือจะคุยด้วยคำสั่งยังไงให้ได้ผลลัพธ์ออกมาดี หรือจะเป็นการใช้ RAG ที่เอาไว้ใช้งานเฉพาะกิจ? อย่างตัวอย่างด้านล่างเป็นการวิเคราะห์การทำงานของ Contact Center ด้วย Speech API กับ OpenAI

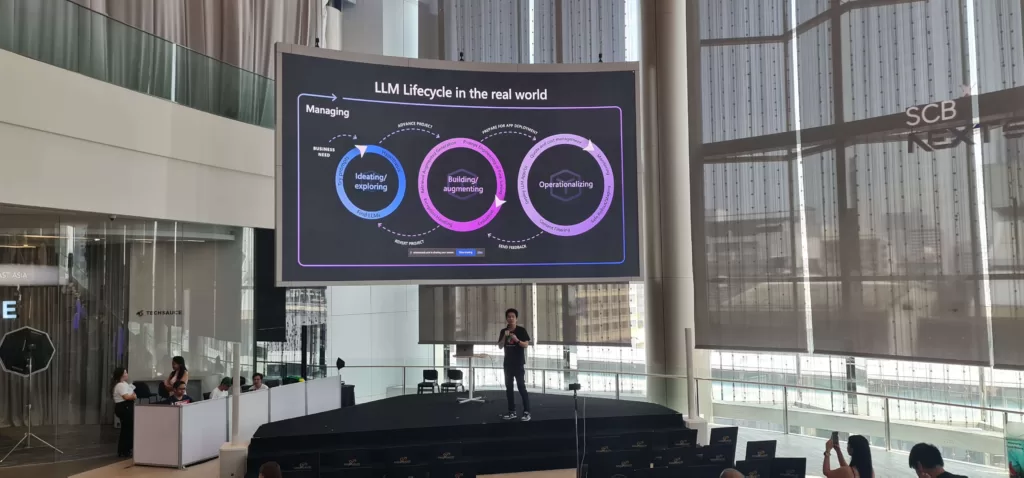

หากเราพูดถึง Ops เราก็จะคุ้นเคยกับ DevOps ตอนนี้มันก็จะมี LLMOps ซึ่งเป็นกระบวนการตั้งแต่ทำ LLM ไปจนถึงการ Deploy ซึ่งปัญหาที่ท้าทายคือ การออกแบบ Prompt ให้เหมาะสมกับแอปที่สุด ให้ตอบยังไง ห้ามตอบอะไร ป้องกัน AI ตอบนอกเรื่อง

ซึ่งในงานพี่พลยัง demo การใช้ Prompt Flow ตั้งแต่เริ่มต้นที่ Azure AI Studio เพื่อใช้งาน LLM บน Cloud นอกจากจะมีเครื่องให้ยังมี model ที่เหมือนจะสำเร็จรูปมากมายเก็บไว้เป็น catalog เยอะแยะเต็มไปหมด เช่น gpt-4 โมเดลตัวเดียวกันกับที่ใช้ใน ChatGPT สร้าง Interface รับ Prompt ทำการออกแบบ Prompt Flow ที่มีหน้าตาเป็น Block ให้เราทำการ Drag and Drop Flow เราสามารถเซฟ Prompt เป็นเทมเพลต สลับโมเดลใช้งาน เพิ่มโค้ด Python Deploy ไป Production รวมไปถึงทดสอบผ่าน ปุ่ม Chat ใน AI Studio ได้เล

#4 Deploy an AI model on Azure Kubernetes Service with the AI toolchain operator

จากคุณ Sirinat Paphatsirinatthi

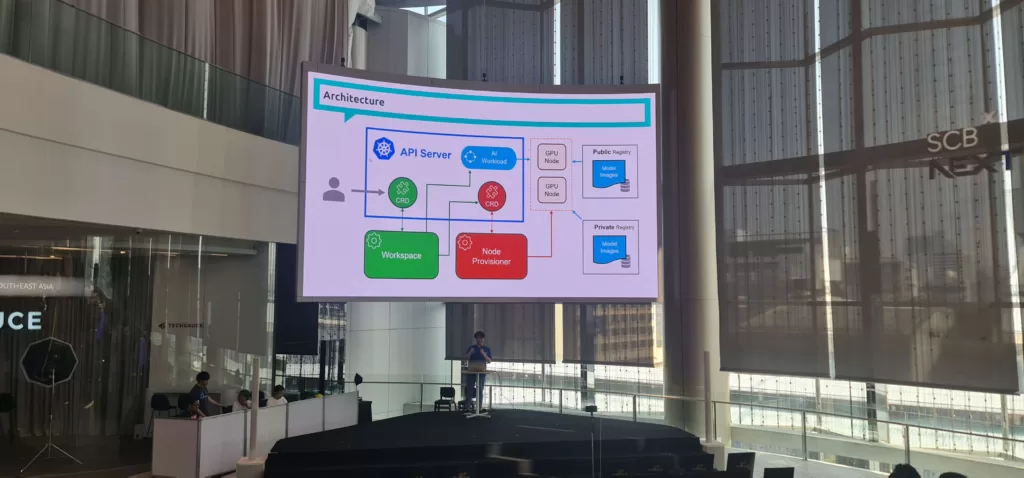

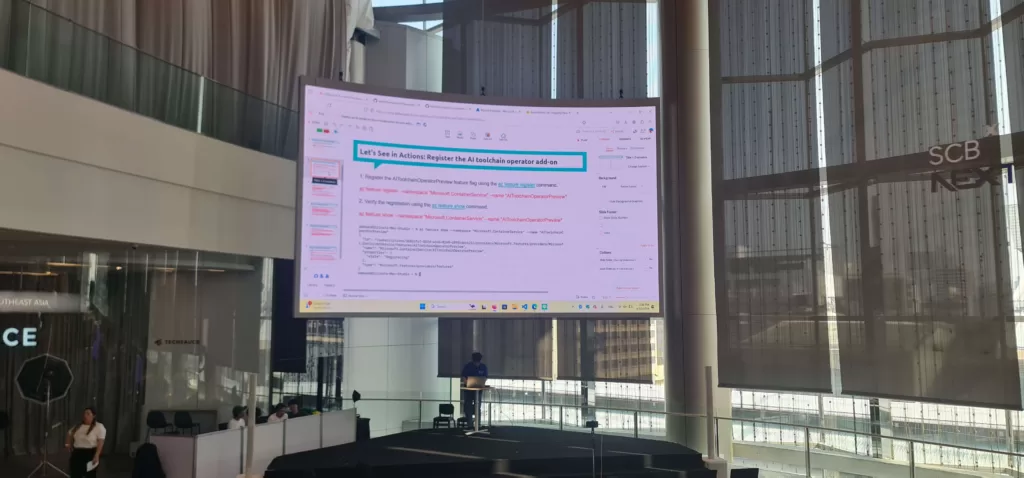

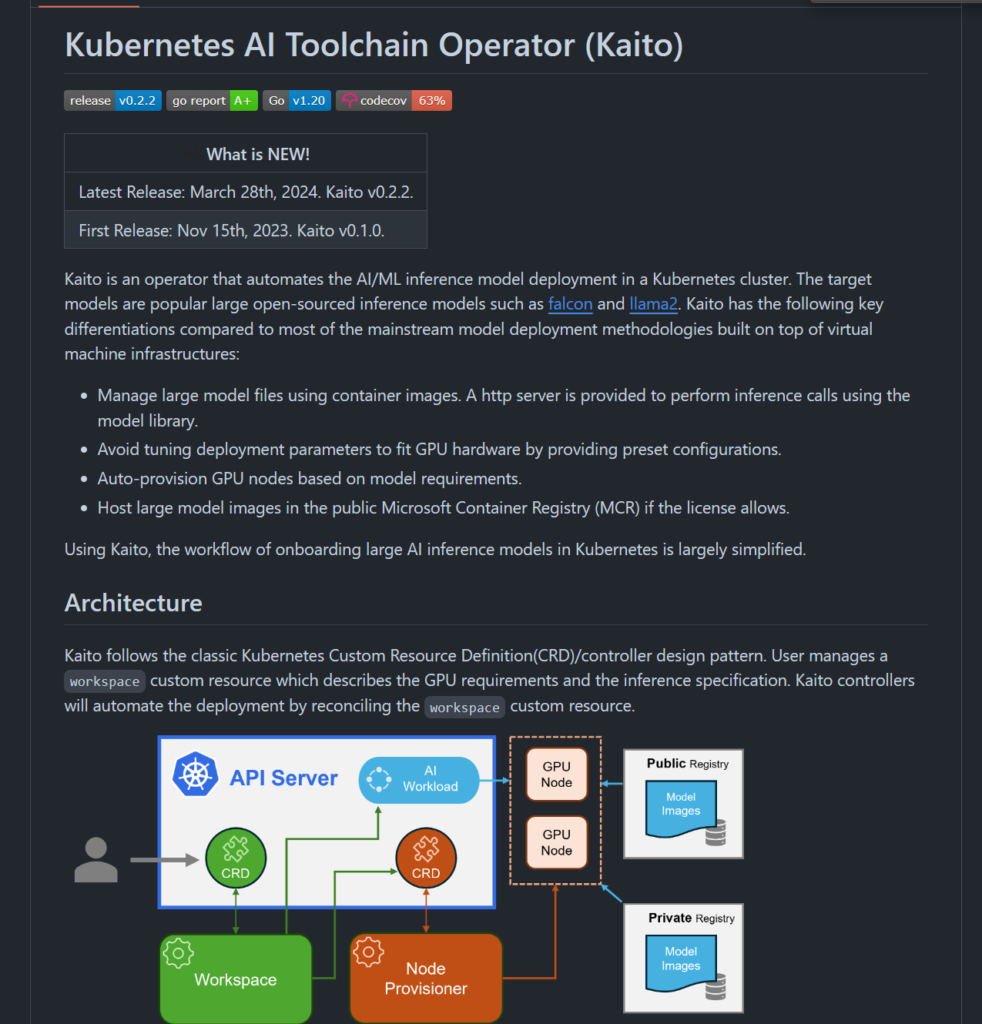

สำหรับ session นี้พี่โอมจะพาเรามารู้จักกับผู้ช่วยในการ deploy LLM แบบอัตโนมัติสำหรับ MLOps นั่นก็คือ “Kaito” ที่ช่วยให้เราสามารถ deploy LLM โมเดลไปยัง บน Azure Kubernetes Service ด้วย AI Toolchain Operator ได้ โดยที่เราไม่ต้องมา config อะไรเยอะแยะ เพราะเค้าได้มีการกำหนดค่าเริ่มต้นมาให้แล้ว (เพราะมี present configuration มาให้) โดยตัวนี้ยังเป็น preview จะต้องใช้ AKS preview ด้วย

ขั้นตอนการใช้งานคร่าวๆ มีดังนี้

ระบุรายละเอียด:

- Workspace (wp)

- Node

- โมเดล (โมเดลทั้งหมดจะถูกเก็บไว้ใน registry)

Deploy workload

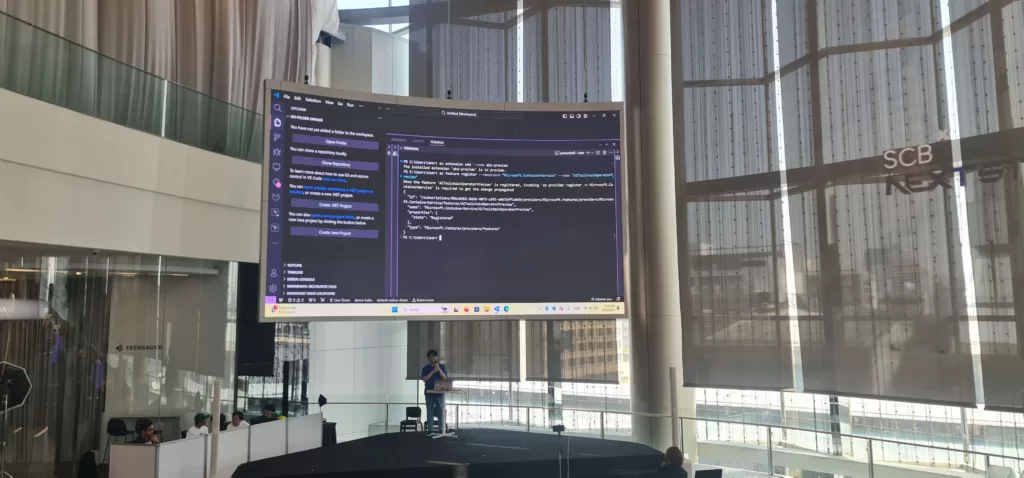

- ใช้ az cli ใน VSCode หรือใช้บน Cloud Shell ก็ได้

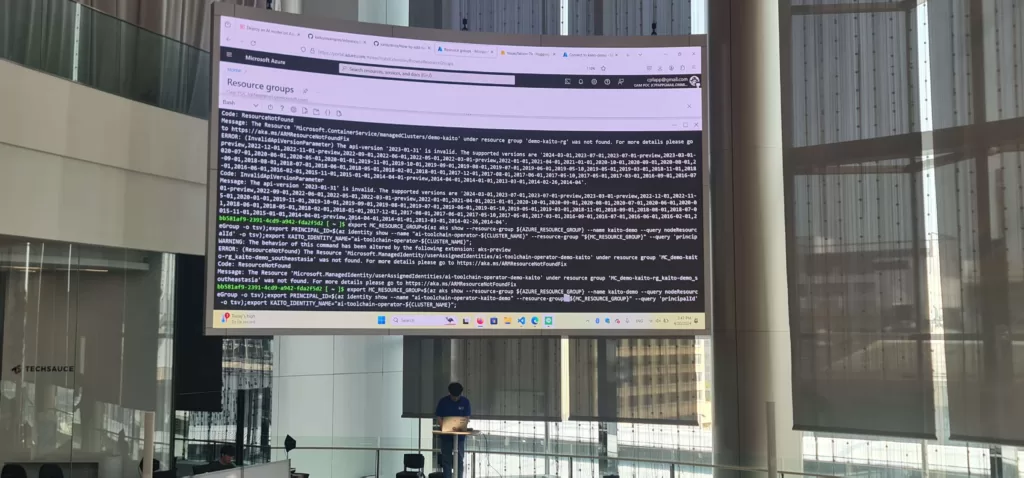

- สร้าง resource group

- สร้าง AKS Cluster

- ตั้งค่าสิทธิ์ให้ Kaito เป็น Contributor (เพื่อ provision GPU node สำหรับ LLM)

ใช้งาน

- Deploy model

- ยิง API ส่ง Prompt ไป

ตัวอย่างการใช้งาน : Azure/kaito: Kubernetes AI Toolchain Operator (github.com)

#5 Build intelligent apps using Azure AI Services and Machine Learning with Apache Spark

จากคุณ Charnthon Limseelo หนุ่มน้อย Microsoft Learn Student Ambassador สุดไฟแรง

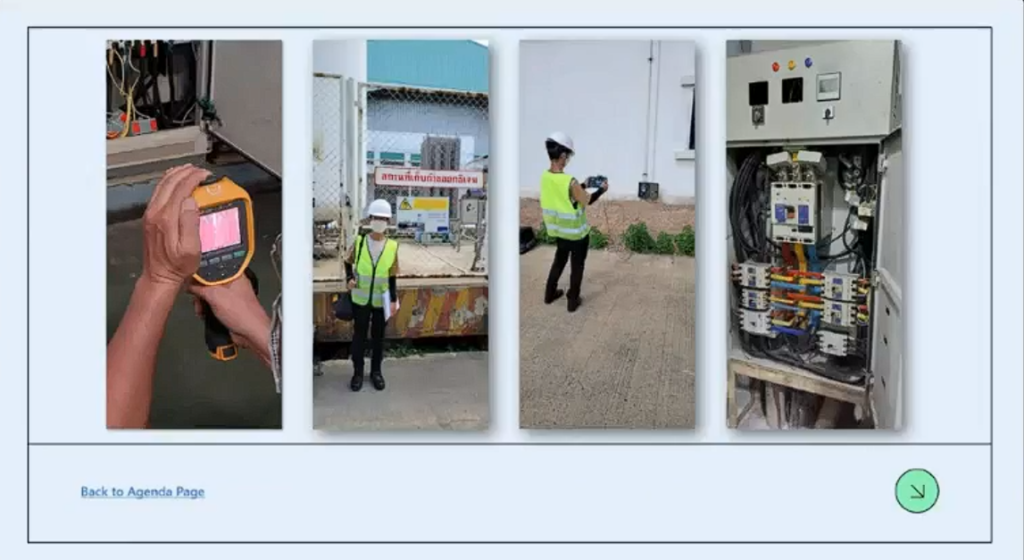

สำหรับ session นี้ของน้องจากมาโชว์ทั้งแอปและฝั่งหลังบ้านของ Engineering แอป โดยที่มาของแอปน้องได้ไปทำงานเกี่ยวกับไฟฟ้า พวกเช็คประสิทธิภาพของอุปกรณ์ผ่านเจ้าเครื่องในภาพนี้

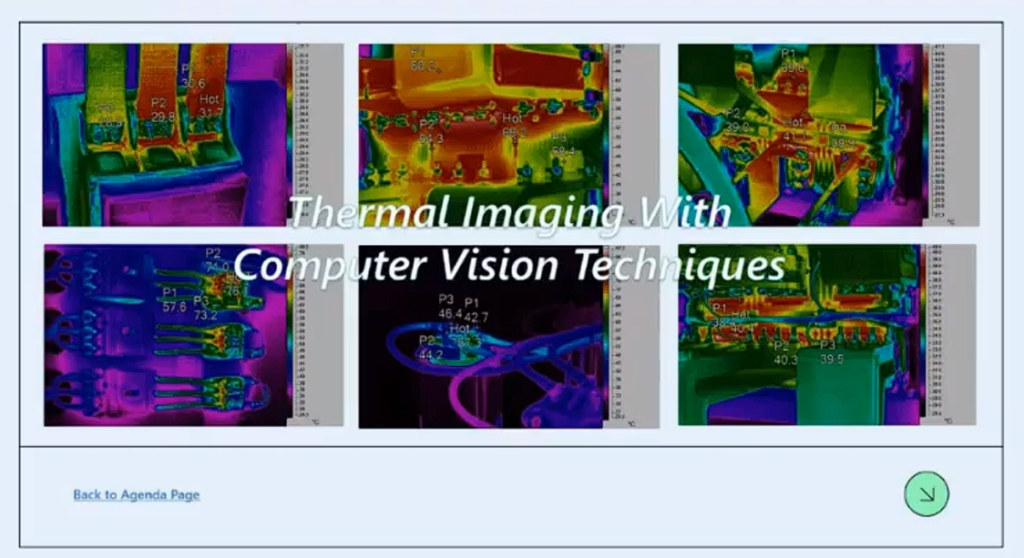

ซึ่งน้องเลยทำเป็นโปรเจกต์ Thermal Imaging with Computer Vision Techniques ที่เอาภาพถ่ายความร้อน (Thermal Imaging) ทำการคัดแยกหรือ classification โดยการใช้ Service บน Azure อย่าง Cognitive Service

อันนี้จะเป็นเครื่องมือในการเก็บ dataset ที่น้องใช้

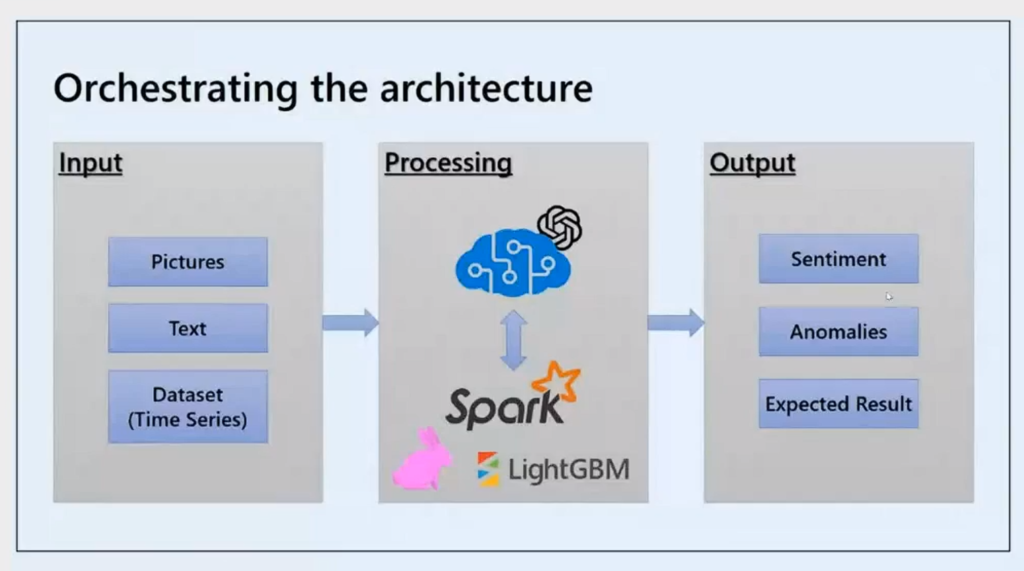

เรามี input ที่เป็นภาพ เป็นข้อความหรืออื่นๆ แล้ว ส่วนของการประมวลผลนอกจากเจ้า Cognitive Service ก็จะมีการเอา Apache Spark ที่เป็นเครื่องมือประมวลผลข้อมูลแบบโอเพนซอร์ส เหมาะสำหรับการวิเคราะห์ข้อมูลขนาดใหญ่ โดย Spark สามารถใช้โหลดข้อมูล คลีนข้อมูล และแปลงข้อมูลก่อนนำไปใช้กับโมเดลได้ ซึ่งในส่วนนี้สามารถเขียนใน Jupyter NoteBook ได้เลย อีกสองตัวคือ Wabbit และ LightGBM ที่เป็นอัลกอริทึมของ ML ที่ใช้สำหรับงานประมวลผลภาษาธรรมชาติ (NLP) โดยเฉพาะงานจัดหมวดหมู่ข้อความ (Text Classification) ทำให้เราจะได้ output มาเป็นพวก sentiment ที่ return ค่ามาเป็น positive หรือ negative นั่นเอง

# 6 Azure Data Factory for Data Workers (TBC)

จากคุณ Chalaivate Pipatpannawong (อาจารย์เวท) และ คุณ Phakkhaphong Krittawat (อาจารย์เอก)

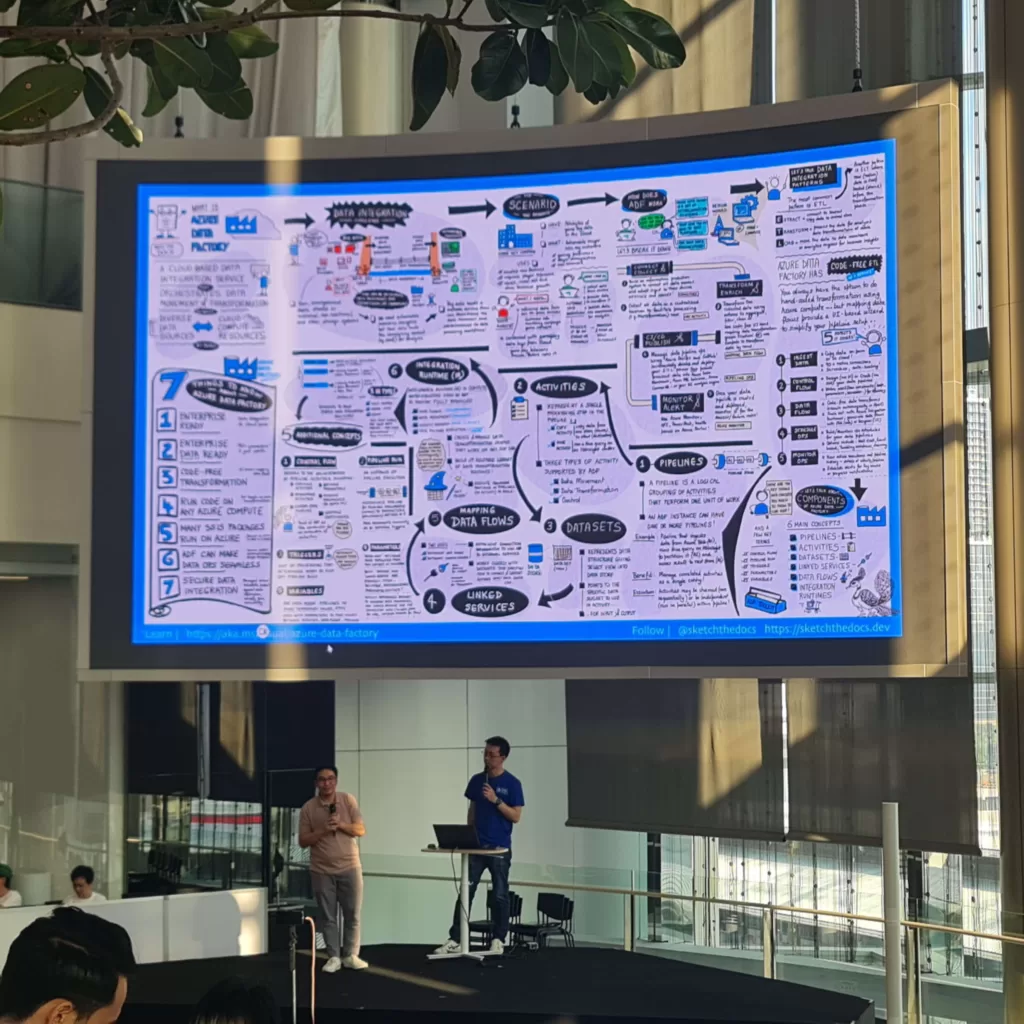

สำหรับ session นี้บอกได้เลย สาย Data ห้ามพลาด เพราะกูรูทั้งสองจะพามารู้จักกับเครื่องมือที่เอาไว้จัดการงานข้อมูลตั้งแต่ต้นจนถึงปลายทางโดย Product หลัก ๆ ที่เปิดมาเลยคือสิ่งที่เรียกว่า “Azure Data Factory (ADF)” ซึ่งเป็นบริการคลาวด์ ที่ออกแบบมาสำหรับการจัดการการไหลของข้อมูล (data pipelines) โดยเฉพาะ

จาก demo จะมีให้เห็นว่าเราสามารถใช้เครื่องมือนี้ได้คล้ายๆ กับ Power Query แต่เจ๋งกว่า ช่วยให้ข้อมูลสามารถรวมรวมข้อมูลทั้งจากที่เป็น Lake และ Datawarehouse แถมยังใช้จัดเตรียม และโหลดข้อมูลจากแหล่งต่าง ๆ ไปยังปลายทางที่ต้องการได้อย่างมีประสิทธิภาพ โดยไม่ต้องเขียนโค้ด หรือจะเขียนโค้ดที่เป็น Script Python เข้าไปก็ได้

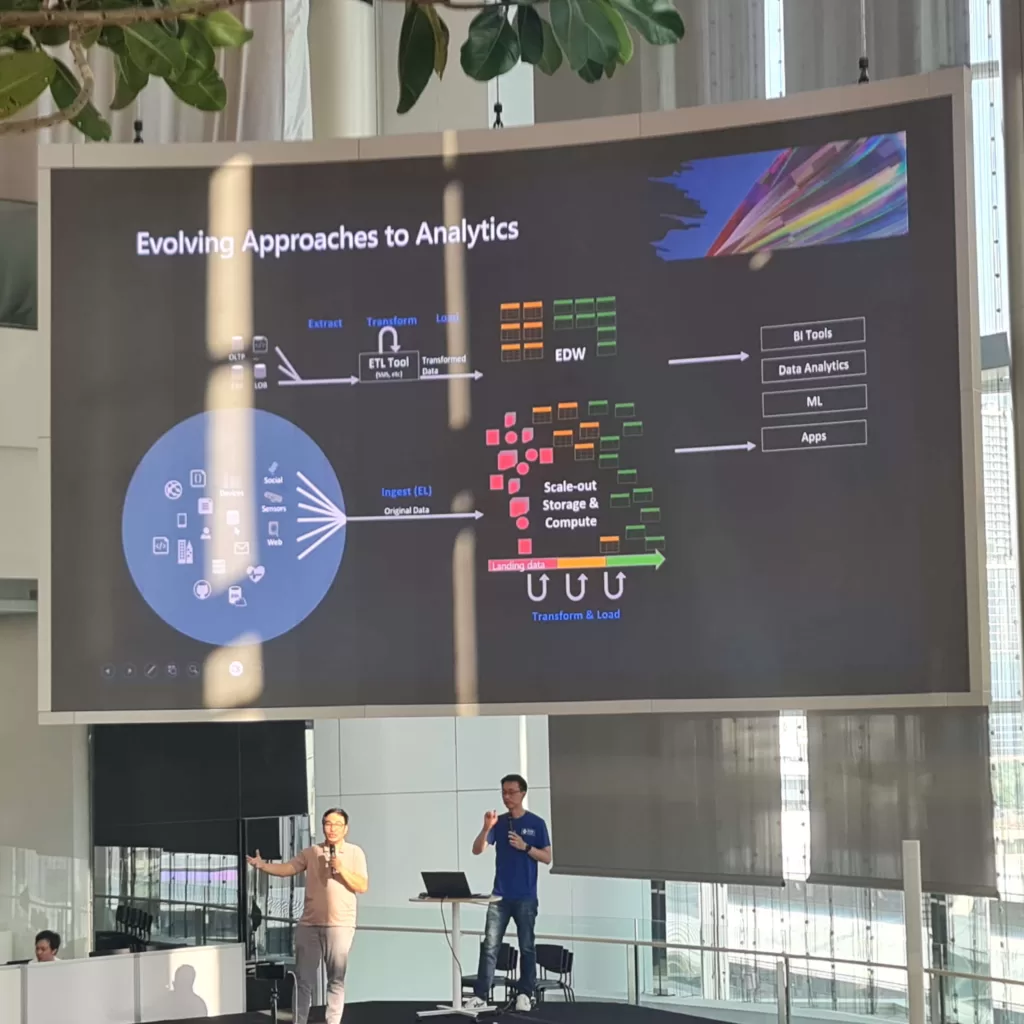

ADF เหมาะสำหรับงานทั้งที่เป็น ETL และ ELT ที่ดึงข้อมูลจากแหล่งต่าง ๆ (เช่น ฐานข้อมูล ไฟล์ เซ็นเซอร์) แปลงข้อมูลให้เป็นรูปแบบที่เหมาะสม และโหลดไปยังปลายทางที่ต้องการ (เช่น Data Warehouse, Data Lake) ทำความสะอาดและตรวจสอบคุณภาพข้อมูลก่อนนำไปใช้งาน เพื่อเตรียมเอาไปสร้างโมเดล Machine Learning ที่ยุคนี้ไม่ว่าจะเป็นองค์กรไหนๆ ก็มีใช้งาน ซึ่งจากที่เห็น demo แอดบอกเลยมามีของให้ใช้งานได้แบบครบจบ แถม UI ก็ใช้ง่าย พอเป็น Cloud แล้วแน่นอน มันเหมาะสำหรับการสเกล

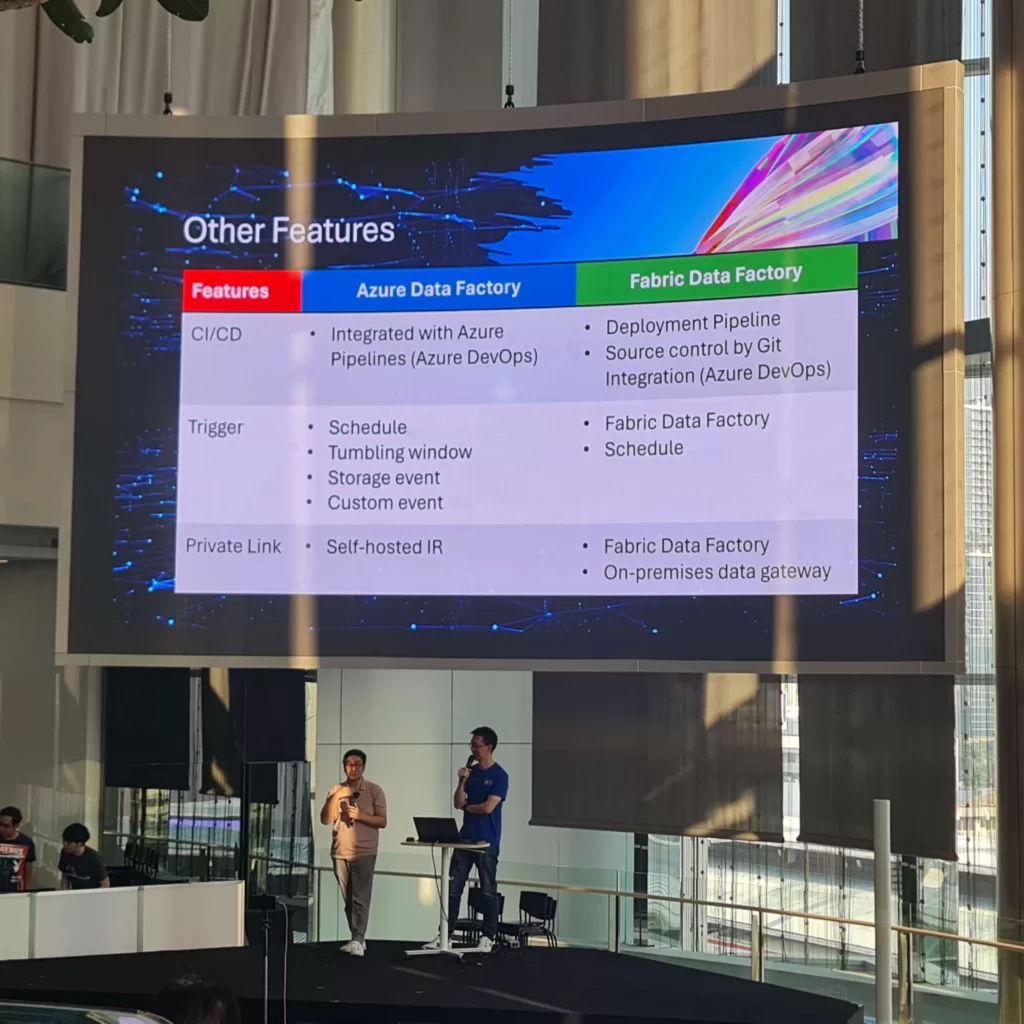

ต่อมาจะมาอยู่อีกตัวที่ชื่อว่า Microsoft Fabric เป็นแพลตฟอร์มแบบครบวงจรสำหรับการวิเคราะห์ข้อมูลบนคลาวด์ รวมเอาเครื่องมือต่าง ๆ เข้าไว้ด้วยกัน ไม่ว่าจะเป็น Data Lake ที่เอาไว้โยนข้อมูลดิบลงไปเฉกเช่น ทิ้ง data ลงทะเลสาบ จะใช้ค่อยไปงม ไม่ต้องมีโครงสร้าง (ปล.อันนี้แอดอธิบายเพิ่ม) ต่อมาหากจะใช้ spark แบบ session น้องโบ๊ทบน Fabric ก็มีให้ใช้ตลอดไปจนถึง Power BI ไม่ต้องไปหาใช้แยกทุกอย่างรวมอยู่นี้ แถมยังมี Copilot เข้าไปอีกเรียกว่าคุยกับ data ได้แบบเป็นเพื่อนซี้กันเลย ซึ่งจะเห็นว่าทั้ง Azure Data Factory และ Microsoft Fabric เป็นเครื่องมือสำหรับนักวิเคราะห์ข้อมูลทั้งคู่ แล้วมันแตกต่างกันยังไง ทั้งสองกูรูก็ได้สรุปมาไว้ในภาพนี้แล้ว 👇

แต่ถ้าอยากได้สรุปแบบสวยๆ จาก Microsoft โดยตรงก็สามารถไปที่ https://learn.microsoft.com/en-us/azure/data-factory/introduction

#7 Building a RAG System with Azure OpenAI, Hugging Face, and MongoDB Atlas

จากคุณ Piti Champeethong

สำหรับ session นี้พี่ฟี่ จาก MongoDB ได้พามาดูวิธีการสร้างระบบ RAG (Retrieval Augmented Generator) โดยใช้ Azure OpenAI, Hugging Face และ MongoDB Atlas

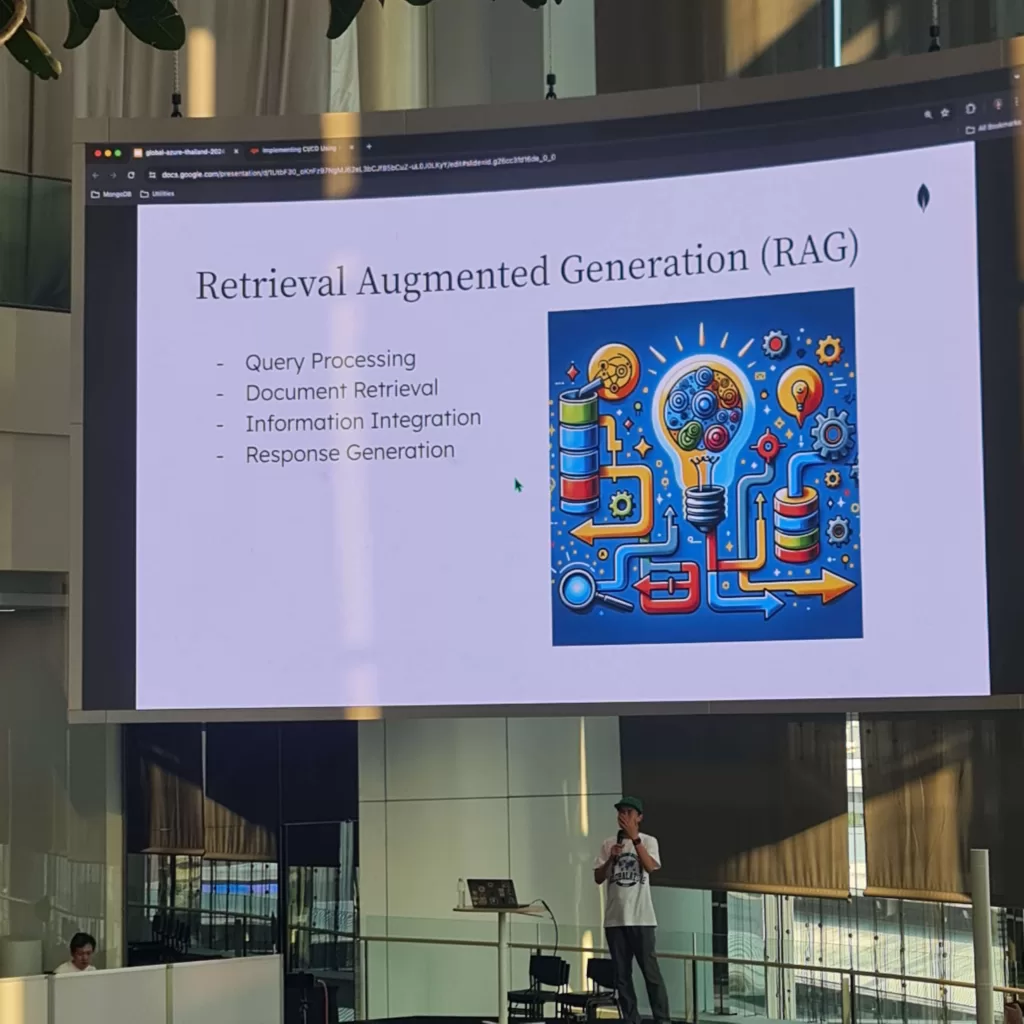

โดยเปิดมาที่ RAG คืออะไร? ถ้าใครไม่รู้จักนี้ถือว่า out มากเพราะในงานมีแต่คนพูดถึงแต่ RAG โดยเจ้า RAG เป็นโมเดล AI เฉพาะกิจที่เราจะเอาข้อมูลของเราไปทำให้ AI มันรู้จัก แต่ไม่ให้เอาไปปนกับที่อื่น เรียกว่า ทำ AI ไว้ใช้ในองค์กร ซี่ง RAG เป็นเทคนิคใน Natural Language Processing (NLP) ที่ช่วยเพิ่มประสิทธิภาพของโมเดลภาษาขนาดใหญ่ (LLMs) ให้สามารถตอบคำถามได้อย่างถูกต้อง ตอบตรง ไม่นอกเรื่อง

กระบวนการทำงานของ RAG หลักจะมีดังนี้

Query Processing: เริ่มต้นด้วยการรับคำถามจากผู้ใช้

Document Retrieval: ระบบ RAG จะไปค้นหาความรู้ แล้วแต่เราจะกำหนด เช่น ในฐานข้อมูล ไฟล์ต่างๆ เพื่อหาข้อมูลที่เกี่ยวข้องกับคำถามมากที่สุด

Information Integration: นำข้อมูลที่เจอมารวมเข้ากับสิ่งที่โมเดลตอบ ส่งผลให้คำตอบที่ได้นั้นมีรากฐานมาจากข้อเท็จจริง ไม่ได้มาจากโมเดลที่ถูกเทรนมาเพียงอย่างเดียว

Response Generation: คำตอบที่สมบูรณ์

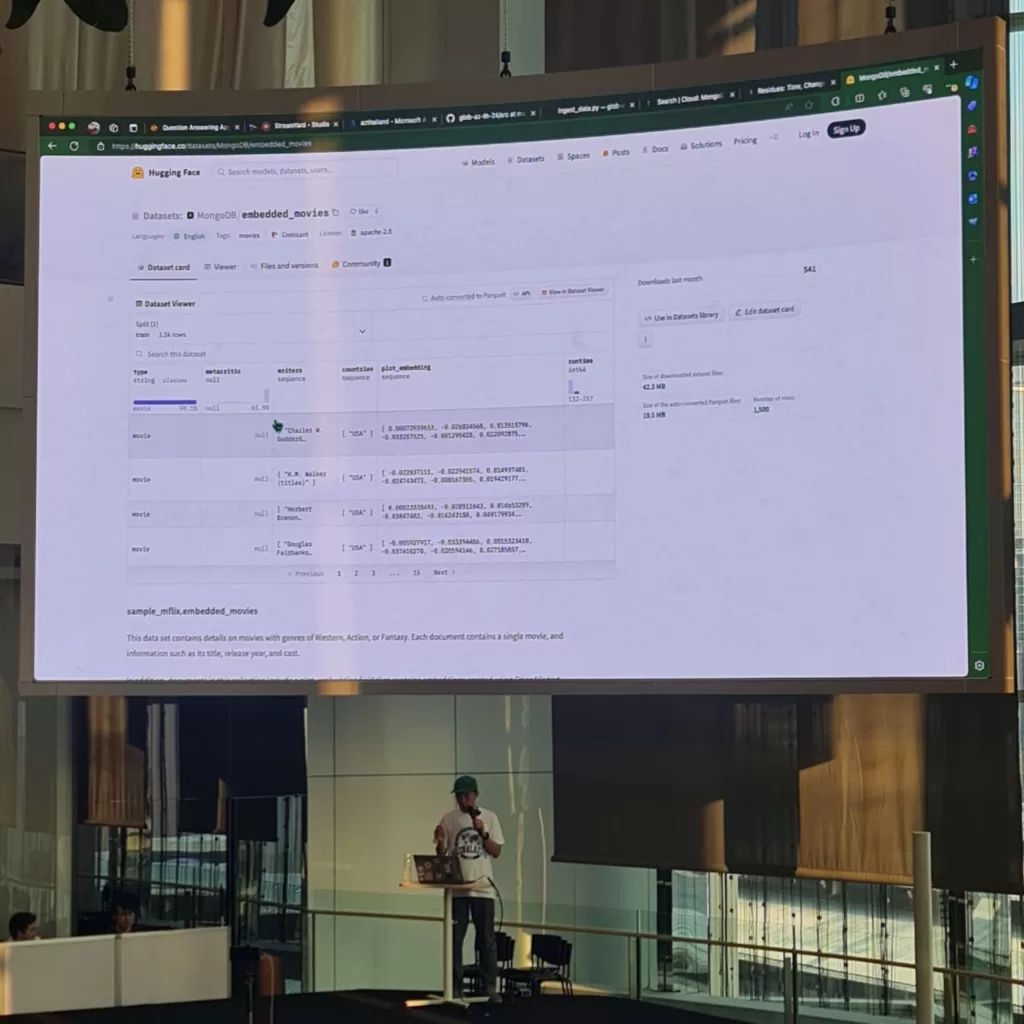

ซึ่งหากต้องการลองใช้งาน MongoDB เค้าก็มีตัวอย่าง Dataset ที่อยู่ใน Hugging Face สามารถไปลองได้ https://huggingface.co/datasets?sort=trending&search=mongodb

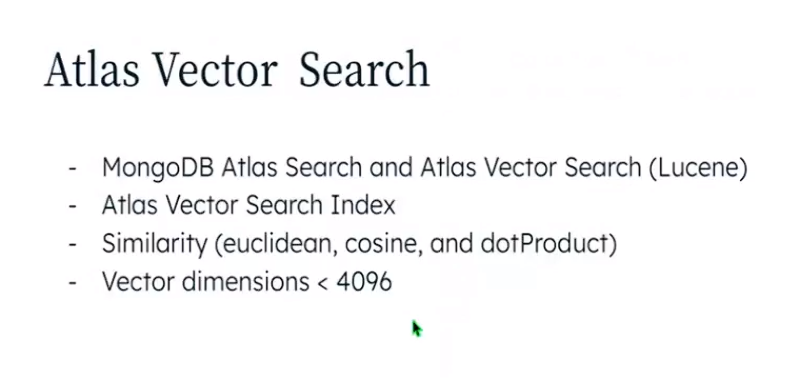

แล้วมันเกี่ยวยังไงกับ vector search ? ตอนที่ทำ RAG เราทำเป็นภาษามนุษย์ eng thai ก็แล้วแต่ แต่คอมมันไม่เข้าใจ มันเข้าใจตัวเลข เราต้องทำให้คำ ความหมายเหล่านั้น ให้กลายเป็นตัวเลข หรือเป็น vector นั่นเอง จะทำให้เราสามารถค้นหาข้อมูลใกล้เคียงได้ เช่น ค้นหา ร้านค้าสำหรับเด็ก มันก็จะไปดูบริบทความคล้ายความเหมือน แทนหาจากคำที่ตรงเป๊ะๆ ตามตัวอักษร โดยใน MongoDB ก็จะมีฟีเจอร์นี้ชื่อว่า “Atlas Vector Search” ซึ่งเราสามารถลองเล่นดูได้จาก dataset ด้านบนและโค้ดตัวอย่างใน repo นี้

#8 AI & LLM Queries with Databricks SQL on Microsoft Azure

จากคุณ Fukiat Julnual และ คุณ Prynn Julnual

สำหรับ session นี้อยู่กับตำนานด้าน Azure นั่นคือพี่ฟู ที่พร้อมกับลูกสาวที่ได้ความเก่งมาเต็มๆ ทั้งคู่มาพร้อมกับความรู้ในเรื่องของ AI และ LLM Query ด้วย Databricks SQL บน Azure

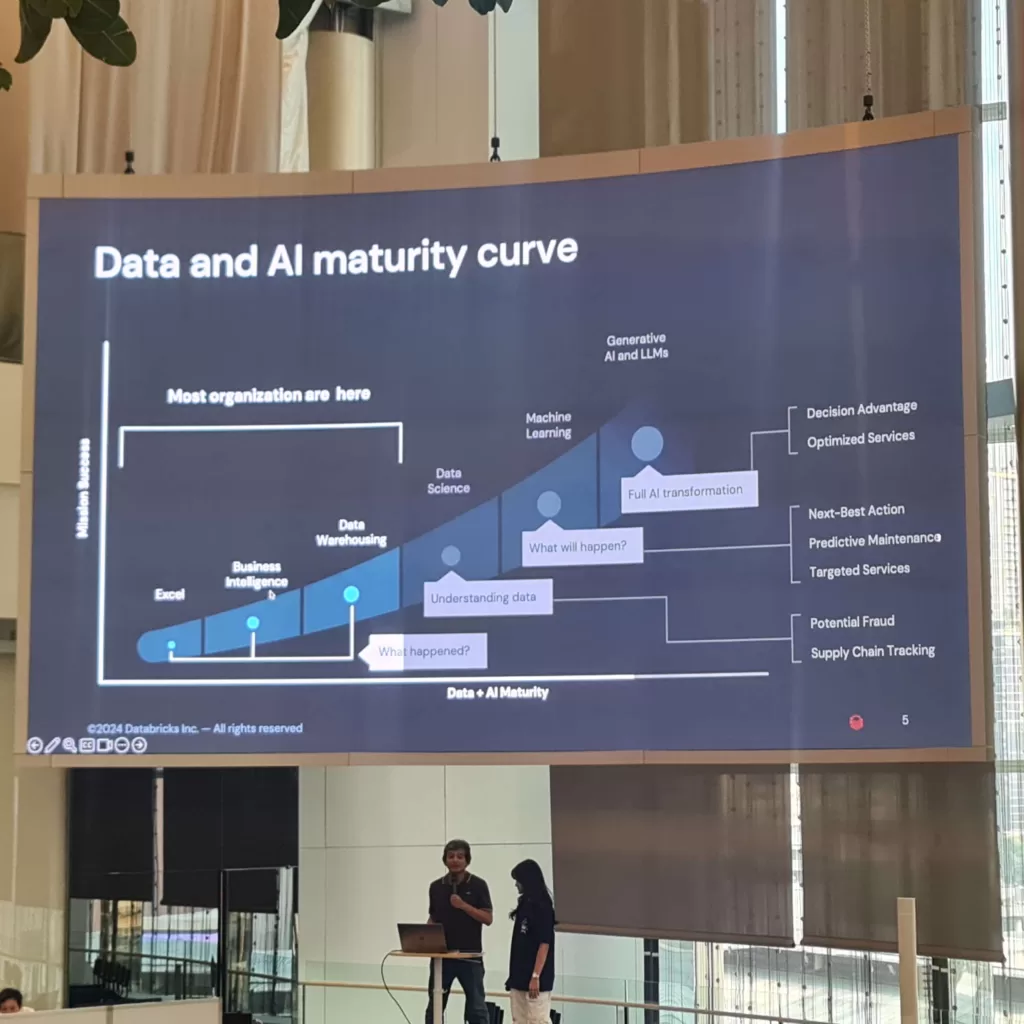

จากภาพนี้เราจะเห็นได้ว่าเราจะเริ่มจาก excel องค์กรเริ่มมีการทำ BI, Data Warehouse แต่อีกครึ่งนึงยังไม่ได้ข้ามไปในฝั่งของ Data Science, ML ไปจนถึง Generative AI และ LLMs อาจจะเพราะต้องใช้งบประมาณ และคนที่เชี่ยวชาญจริงๆ

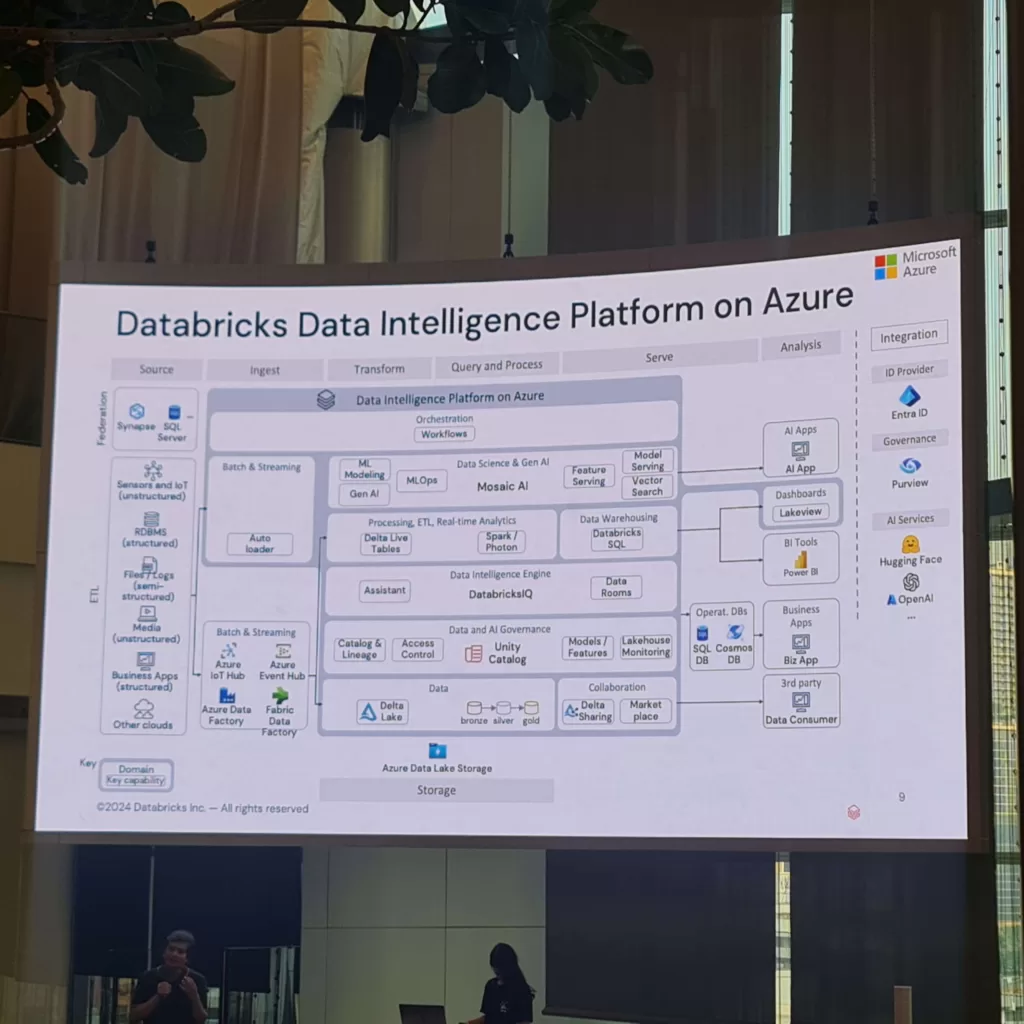

แล้วตัว Databrick มันทำอะไรได้บ้าง มันก็จะสามารถทำตามกระบวนการด้านบนได้เลย จะเห็นได้ว่าครบวงจร

ตั้งแต่ดึงมาจาก DataSource ต่างๆ ทำได้ทั้งแบบ Batch และ Streaming ประมวลผล Big data โดยช้ Apache Spark และ Delta Lake ไปจนถึงสร้าง Dashboard และ report ต่างๆ และต่อกับบริการอื่นๆ อย่าง ID Provider, Purview และ Hugging Face

#9 Microsoft Sentinel Simplified: Content Hub Spree & “Incident Tasks” like a Boss

จากคุณ Saran Hansakul

สำหรับ session สุดท้ายเป็นของเจ้าแม่สายซีเคียว จาก Thai CySec ที่จะมาพาเราไปรู้จักกับ Microsoft Sentinel และของข้างในที่ชื่อว่า “Content Hub” แต่เปิดมาด้วยประเด็นชวนให้คิดว่า “เราใช้อะไรส่อง logs” Azure Monitor? Grafana? Prometeus? แล้วถ้ามีเครื่องมือส่อง log ที่เติมความ Intelligence เข้าไปหละ

ซึ่งเจ้า Microsoft Sentinel เป็นบริการเอาไว้วิเคราะห์ log สำหรับป้องกันพวกภัยคุกคามต่างๆ ที่จะมาเล่นงานระบบเรานี่แหละ ซึ่งเจ้าตัวนี้วิธีการคิดเงินพี่ซาร่าบอกแอบซับซ้อน เพราะมันต้องไปเรียกหลาย resource มาแต่มันมีพวก AI และ Machine Learning ช่วยตรวจสอบ Pattern ของ Log ได้ ซึ่งเจ้า Sentinel เนี่ยเป็นเหมือนศูนย์กลางที่จะไปต่อกับหลายๆ source ได้

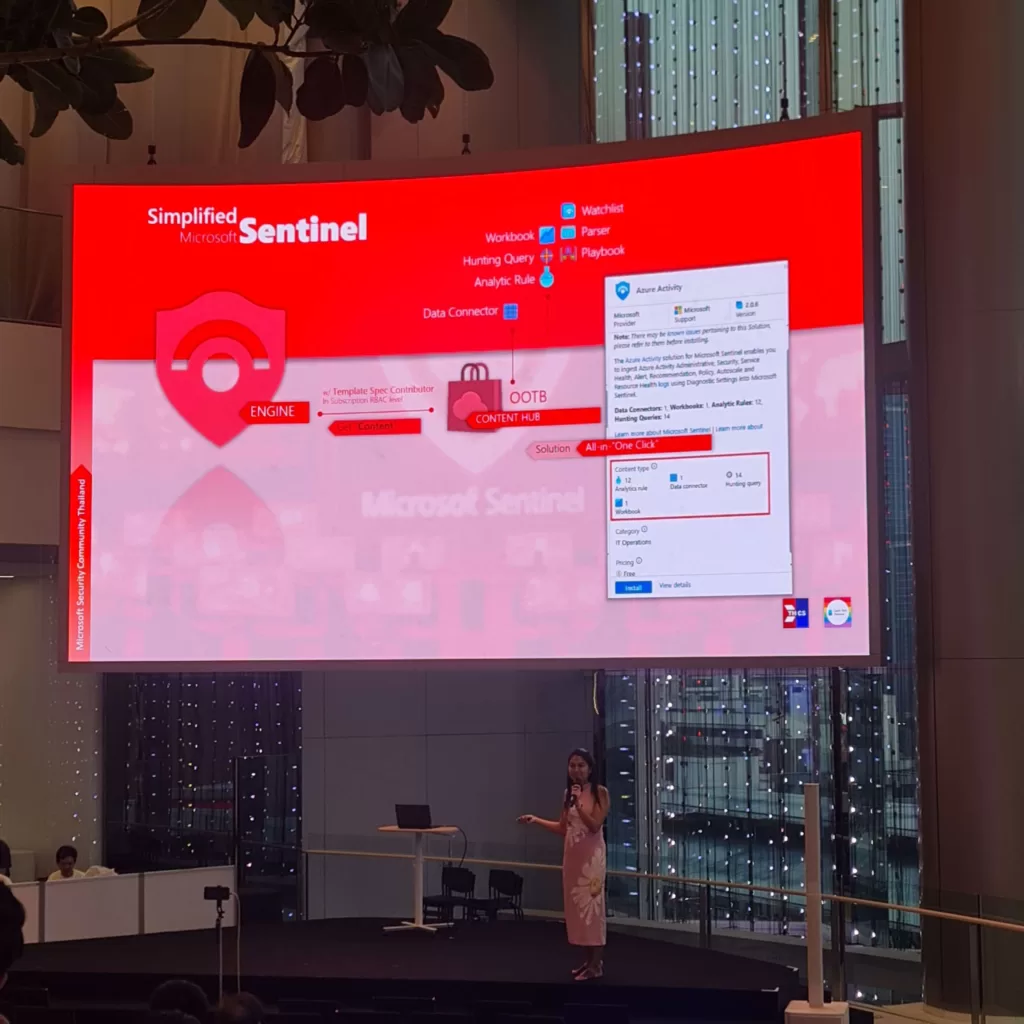

ปัจจุบัน Sentinel ใช้สิ่งที่เรียกว่า Content Hub เปรียบเหมือนถุงช็อปปิ้ง ที่รวม Tools ที่จำเป็นเอาใส่ถุงมาให้แล้วไปต้องไปซื้อแยกมาทีละอัน ฟีลแบบซื้อทั้งเซ็ต หรือจะเรียกว่า out of the box (OOTB) โดยจะรวมมาในรูปแบบที่เป็นเทมเพลต ได้มาแล้วเราก็สามารถแก้ไขเองได้หมดเลย แล้วถ้าเราอยาก demo sentinel มันต้องมี log เข้ามาแล้วถ้าเจออะไรที่น่าสงสัยมันจะดีดมาเป็น incident โดยคำนี้หมายถึงสิ่งที่บอกว่าความไม่ปลอดภัยกำลังมาเยือน แต่ถ้าไม่มีความเสี่ยงเข้ามาก็ demo ไม่ได้ดิ แต่ใน sentinel เราสามารถเสก incident ขึ้นมาเองได้ง่ายๆ ใน click เดียวไม่ต้องไปสร้าง ransomware แล้วมาโจมตีเองหลายขั้นตอน

แล้วในฟีเจอร์นึงของ incident จะมีสิ่งที่เรียกว่า Task โดย sentinel จะเจน alert ขึ้นมาได้ log จะต้องตรงกับ rule ที่เราตั้งไว้ เราจะเซ็ตเป็นคิวรี และจะมีบาง incident ที่เราไม่สามารถลบได้ เช่น incident ที่ส่งมาจาก connector บางตัว ถ้าอยากจะแก้ไขต้องไปที่ต้นตอ เมื่อเปิด log ขึ้นมาคนที่คอยเฝ้า log สิ่งที่คนเฝ้าจะต้องทำเวลามี alert ขึ้นมาคือ คลิกเข้ามาดู > ตรวจสอบ > แล้วก็ triage คัดแยกแล้วส่งต่อให้ฝ่ายที่เกี่ยวข้องซึ่ง Sentinel ก็จะมีรองรับตรงนี้ในการสร้าง Task และทำการ Invite Team นั่นเอง

และนี่ก็เป็นบางส่วนที่แอดจดๆ มาแบบไวๆ ซึ่งถ้าใครอยากดูแบบเต็มๆ สามารถดูย้อนหลังได้ที่ลิงก์นี้ได้เลยคร้าบบบ https://web.facebook.com/SparkTechTH/videos/1082178842845442/